Apple efface sa fonction de scan de photos pédopornographiques 🆕

Apple semble avoir remisé au fond d'un placard sa fonction de détection d'images pédopornographiques dans la bibliothèque Photos d'iOS et iPadOS. Dans la page qui détaille les nouvelles mesures de protection des jeunes utilisateurs, cette fonction en particulier — une des trois annoncées au cours de l'été — a complètement disparu du descriptif.

Précédemment, la page indiquait que cette fonction d'analyse des images avant leur envoi dans la photothèque d'iCloud faisait l'objet d'un développement plus approfondi avant son lancement (aux États-Unis d'abord). Il s'agissait pour Apple de se donner du temps au vu des nombreuses critiques essuyées par son initiative.

Apple repousse ses mesures controversées de lutte contre la pédopornographie

Depuis la sortie d'iOS 15.2 cette page a été remaniée et expurgée de toute référence à cette fonction, même à une date indéterminée. Une modification qui a l'allure d'un enterrement pur et simple.

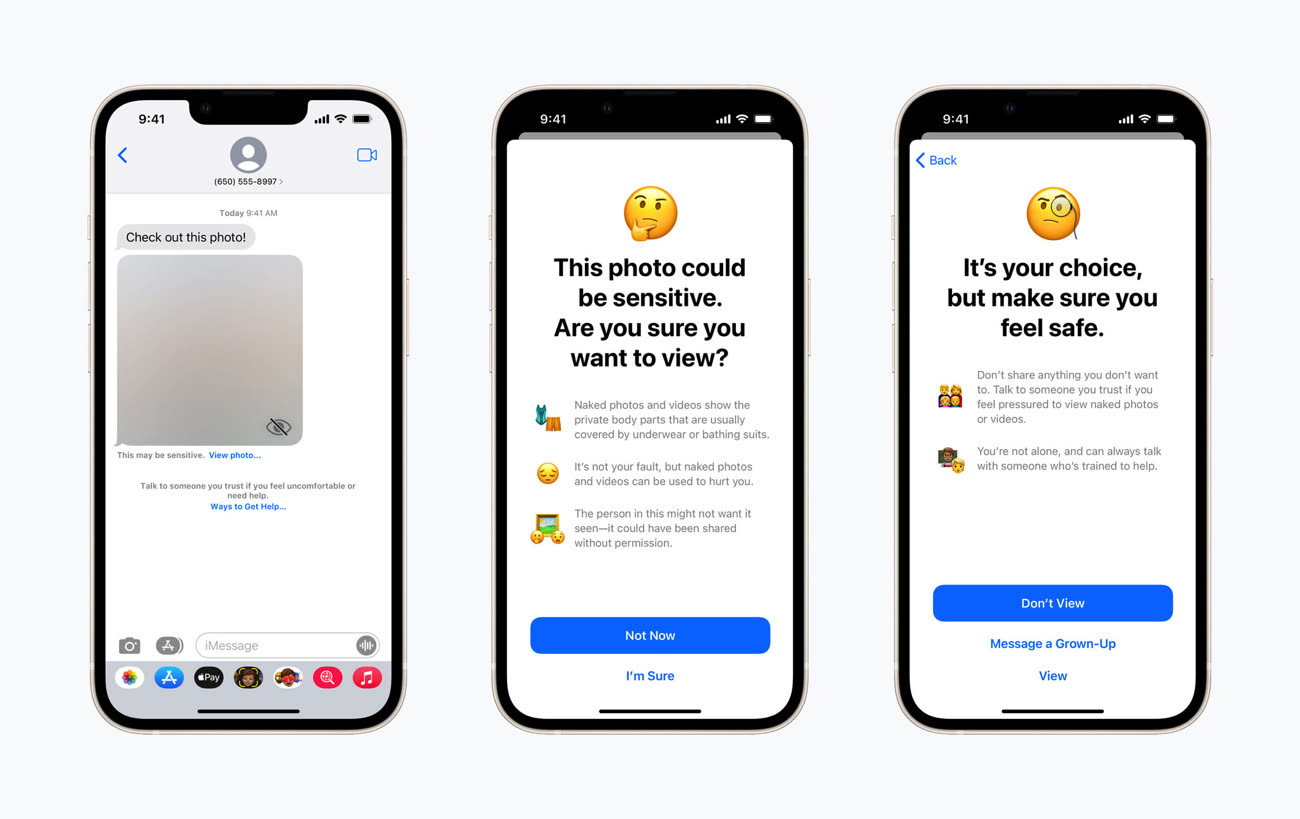

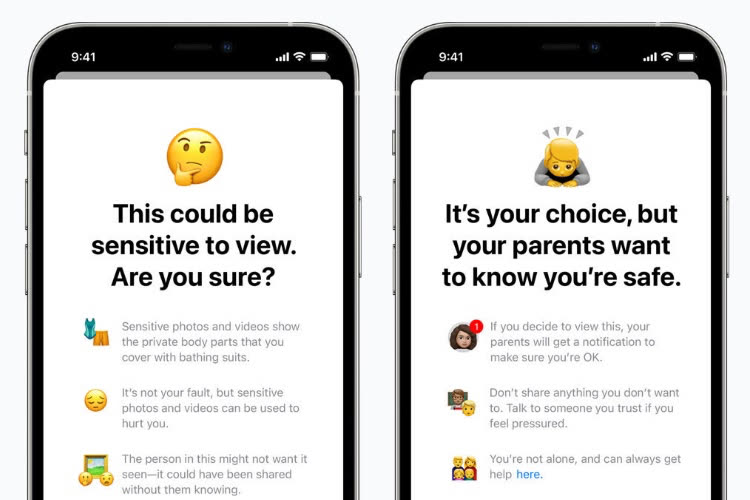

Apple a conservé deux fonctions qui sont inaugurées auprès du public américain : d'abord le floutage d'images de sujets supposément nus dans les échanges au sein de Messages, ensuite des ressources fournies par Siri, Spotlight et la recheche de Safari sur l'exploitation sexuelle de mineurs. Le planning pour un déploiement à l'internationnal reste inconnu.

Protection de l'enfance : la fonction de floutage des photos sexuellement explicites dans Messages apparait dans iOS 15.2 🆕

Mise à jour 18h — Apple a peut-être retiré les références à la détection des photos pédopornographiques dans le descriptif de son site consacré aux mesures de protection contre l'enfance, le constructeur n'a pas du tout enterré sa technologie. Il s'agit toujours d'un report, pas d'un abandon, a affirmé une porte-parole à la presse US. Comme Apple l'avait expliqué en septembre, il s'agit de prendre son temps pour prendre en compte les retours des spécialistes, des chercheurs et des groupes de défense de la vie privée.

@DahuLArthropode

"De même que tu dois signaler un acte pédophile si tu en constates un, ce qui ne fait pas de toi un justicier déguisé en chiroptère."

En premier il est bon de préciser que : Signaler et dénoncer sont des pratiques définies et encadrées très précisément par le code pénal. A savoir que si le signalement est dénué de toute objectivité de faits peut se retourner au pire contre l’auteur.

Apple peut dénoncer, mais en aucun cas ne peut se prévaloir de -par exemple-flouter des images qu’elle juge immorales, sauf si le droit l’y oblige. Et ce n’est pas à Apple à décider du droit. A ce propos, cette fonction de floutage peut tomber sous le coup de la loi en France puisque elle peut potentiellement enfreindre la loi de 1881 sur la liberté de la presse qui régi aussi de la liberté d’expression que ce soit dans le domaine public et privé. (Ici serait concerné les règles concernant le privé).

Il serait temps que le justice s’intéresse à ces règles abusives propagées par YouTube, Facebook, etc. et maintenant Apple qui placent « leur » morale unilatéralement et au dessus du droit !

@Sindanárië

"par exemple-flouter des images qu’elle juge immorales, sauf si le droit l’y oblige. Et ce n’est pas à Apple à décider du droit."

Non, c’est aux parents. Apple installe juste une fonction qui permet de contrôler le floutage ou non des images tendancieuses.

@DahuLArthropode

« De même que tu dois signaler un acte pédophile si tu en constates un, ce qui ne fait pas de toi un justicier déguisé en chiroptère. »

Si je me mets à les traquer, si.

Le problème n’est pas de dénoncer, mais la façon d’aller chercher l’information pour le faire.

@fte

Quand les sociétés privées prennent des initiatives elles sont critiquées car ce n’est pas leur rôle de se substituer à la justice/aux états… et lorsqu’elles ne font rien… elles se retrouvent sous le feu des critiques mais dans l’autre sens…

Personnellement je trouve que c’est une bonne chose que les entreprises comme Apple utilisent leurs moyens/technologies pour aider à combattre un peu ce qu’elles ont facilité avec leurs produits.

@Pattedechat

En effet, ce sont les tuteurs de l’enfant qui décident en activant la fonction 🤷♂️

@Pattedechat

Les États voulaient. Les gens aussi. Ils ont.

@Pattedechat

Je pensais que c’était une protection parentale.

Dès cet instant ça n’est plus Apple mais bien moi qui décide.

Par contre si ça n’est pas le cas alors effectivement ça n’est pas normal.

@Pattedechat

Et du coup, vous voulez montrer autre chose que votre patte de chat c’est ça?

@Pattedechat

++

Tant mieux.

dommage

Heu arrêtez de vous enflammez pour rien ça ne concerne que les enfants et c’est activable/désactivable

@jul69

C’est un point intéressant. Ce qui n’existe pas chez les autres 😤

@jul69

« Heu arrêtez de vous enflammez pour rien ça ne concerne que les enfants et c’est activable/désactivable »

Mais pas du tout.

Tu mélanges tout ou tu ne parles pas de la News.

@Bigdidou

Je répondais aux commentaires plus au du fil car tout le monde mélange tout. effectivement c’est un autre sujet que celui qui est évoqué dans la News. Même si la News y fait référence…

Quelque peu ridicule xar l'analyse des hash sur les Cloud de Google, Amazon ou Microsoft est déjà opérationnelle depuis plusieurs années.

@nespresso92

+1 les gens ne savent pas comment fonctionnent les systèmes qu’ils utilisent. Quand on parle de hash ça parlent seulement à une minorité et le reste croient qu’on a besoin de stocker ou je ne sais quoi pour avoir l’information.

@tupui

> Quand on parle de hash ça parlent seulement à une minorité et le reste croient

> qu’on a besoin de stocker ou je ne sais quoi pour avoir l’information.

Ou que cela se fume. ;-)

@nespresso92

Sur la version Apple il y avait possibilité de faux positifs contrairement aux hashs standard.

@koko256

L'informatique n'est pas une science exacte. Shazam se trompe aussi. Mais ces erreurs sont à la marge.

Je n'ai jamais vu dans la presse un souci / scandal sur une erreur qui aurait incriminée un personne innocente concernant les autre GAFA.

@nespresso92

La cryptologie est une science exacte et si le hash (même les vieux cassés comme MD5) de deux photos prise avec un appareil photo sont différentes, leur hash le sera aussi. Par contre c'est a priori faux avec le Apple hash (je ne sais plus le nom qu'ils lui ont donné d'ailleurs puisque ce n'est pas une fonction de hachage) puisqu'une photo retouchée va avoir le même hash donc on peut imaginer que deux photos qui se suivent sans bouger l'appareil aussi. Shazam est un bon exemple analogue. Il peut se tromper mais n'ira pas faussement transmettre ce que j'écoute à des humains quand il se trompe.

@koko256

Tout d'abord je ne sais si le hachage des photos en question relève d'une simple empreinte numérique comme pour la musique, ou si c'est un hachage cryptographique. Donc votre point peut inexacte.

De plus, alors que le hachage d'un fichier hache les bits individuels de données du fichier, le hachage d'image fonctionne sur un niveau légèrement plus élevé. La différence est qu'avec le hachage d'images, si deux images semblent pratiquement identiques mais sont dans un format ou d'une résolution différent (ou il ya une petite corruption, peut-être en raison de la compression), le hachage sera au même nombre, donc identique. Cela infirme donc vos dires.

De plus, il n'y pas de "hash Apple" ou Google ou tout autre GAGAM. Le hash des photos incriminées relève de plusieurs base de données externes officielles (ex. National Center for Missing and Exploited Children).

Pour conclure, ce bruit médiatique est ridicule, car l'analyse se fait déjà sur Gmail ou Outlook.com ainsi que sur leurs services Cloud ou sur Amazon concernant les serveurs hébergeant des photos. Et là personne ne s'est offusqué.

😂 tout ça pour ça! 😂

Ça montre qu’une chose que tout absolument tout est analysé de nos jours, n’importe l’endroit où ça se trouve.

Même s’ils disent que non, cette fonction est retirée ou n’existe pas.

@marenostrum

En même temps comment voulez vous avoir des services comme Siri ou Google sans rien analyser. A un moment faut voir aussi que rien n’est magique et que pour des fonctions qui peuvent paraître très simple on doit aller très loin. Allez lire les blogs techniques de toutes ces entreprises.

@ tupui:

Euh, ouais, on ne veut pas forcément Siri, perso j'ai jamais utilisé... Est-ce les clients qui ont réclamé Siri? Ou est-ce Apple qui l'a imposé? Je peux gicler toutes les api concernant Siri? Expurger cette merde de mes appareils Apple?

@debione

Siri est un exemple parmi d’autres. Juste te donner un itinéraire sur une carte avec une bonne estimé demande des donnés utilisateurs. Si tu veux un traducteur comme deepl ou Google translate, tu dois collecter des données pour entraîner les modèles. Si tu utilises que des données libre de droit (bon courage, le vrai libre de droit est extrêmement limité) et bien tes modèles seront tellement pourri que personne ne voudra utiliser ton produit (ps. je travail dans le domaine). Tous les jolis résultats que Google/openAI et autre donnent avec leurs super modèles utilisent des donnés comme les sous titres de films ce qui est totalement illégal pour du commercial et juste toléré pour la recherche.

Donc Google / Facebook &Co continuent de tout scanner )photos , e-mail,…) sur leurs servers

mais pour eux , Tout le monde s’en contre fout 🤪

Mais Apple le fait aussi sur ses serveurs, depuis au moins 2 ans!

https://9to5mac.com/2021/08/23/apple-scans-icloud-mail-for-csam/

https://www.societe.com/actualites/icloud_apple_confirme_scanner_les_photos_de_ses_utilisateurs-41652.html

@r e m y

“Tout”

Les photos ne sont pas scannées par Apple

Ça veut dire quoi "Tout" ???

Quant à "Les photos ne sont pas scannées par Apple", les articles que j'ai mis en lien disent l'inverse. Apple a confirmé les scanner sur ses serveurs à la recherche d'images CSAM depuis 2019 au moins.

@r e m y

C’était pour vérifier leur nouveau scanner scanne bien 😃

Les pedophiles peuvent rester sur iOS

@ClownWorld 🤡

"Les pedophiles peuvent rester sur iOS "

Sérieusement, tu n’en as pas marre d’être con. Tu sembles un minimum cognitif, tu pourrais proposer de belles choses en ce monde dans lequel tu nous parles ?

Ton mal être te regarde uniquement toi avec toi. As-tu déjà consulter un psy pour livrer ton mal être et te sentir mieux ?

@Amaczing

Il a raison pourtant

Les pedophiles n'avaient plus qu'apple et maintenant ca sent le roussi

@raoolito

N’importe quoi… leurs moyens ne sont pas plus limités ailleurs que chez Apple !

@raoolito

« Les pedophiles n'avaient plus qu'apple et maintenant ca sent le roussi »

Quelle naiveté !

Les solutions techniques pour contourner la proposition d’Apple ne manquent pas…

@ClownWorld 🤡

"Les pedophiles peuvent rester sur iOS "

Si on considère comment tu architecture tes dires, la tombe que tu te construit va être un monument plus spectaculaire que la grande pyramide 😂

@Sindanárië

Il y a encore plus con dans ce fil, même si j’imaginais ce difficilement possible.

Par exemple d’un Dahu : « Bref : la pédopornographie est mieux protégée aujourd’hui que les journalistes ou les lanceurs d’alerte. »

C’est remarquable.

"les échanges au sein de Messages"

Les échanges au sein... mes échanges préférés.

Mais du coup, on s’offusque mais en attendant, tapez, “voiture” “montre” “avion” “chien” bizarrement l’iPhone saura reconnaître.

La reconnaissance d’écriture est certes bien pratique mais en attendant nos photos ont bien toutes été scannee à un moment ou un autre…donc bon. Jolie blague.

@Ralph_

Complètement

La seule dif c'est l'echange et la comparaison du hash

@Ralph_

Si il n’y avait qu’Apple qui scanne… d’autres font bien pire et continuent sans aucun frein !

Ils ont compris que en fait il y en avait beaucoup plus que prévue

Je sors de 1 mois sans smartphone... Et ben, qu'est-ce que c'est bien, que de temps gagné, que de bonheur absolu...

Va falloir que je le fasse plus souvent!

A croire que certains avaient peur de perdre des contacts avec cette mesure...

Pages